巨头都在追逐的眼球追踪技术,究竟能带来什么?

发布时间:2017-08-03 10:32 来源: 芬莱科技

人的身体有视觉、听觉、嗅觉味觉、触觉和运动五大感知系统,然而我们所接收的80%的信息都来自于眼睛。

眼睛不仅是我们的输入主设备,也是我们的输出设备。俗话说:“眼睛是心灵的窗户”,情侣之间的爱意也是靠眼波的流连婉转。眼睛透露出我们很多的“秘密”。

目前我们的人机交互还主要靠的是键盘、鼠标、触摸,这些输入并不直接也不高效。人机互动的发展方向应该是越来越人性化,要能“听”、能“看”,能主动探索和回应需求。

眼球追踪让机器更懂你

眼球追踪就是这样一个让机器人更懂人类的技术。眼球追踪主要是研究眼球运动信息的获取、建模和模拟。一是根据眼球和眼球周边的特征变化进行跟踪,二是根据虹膜角度变化进行跟踪,三是主动投射红外线等光束到虹膜来提取特征。

眼球追踪技术的发展由来已久,应用的场景广泛。在心理学实验中,可以通过人的瞳孔变化来监测一个人是否在说谎;在广告效果监测方面可以通过人眼注视点的移动来判断人的偏好;而到了人机交互方面,眼睛可以取代键盘、鼠标和触屏,一些手机可以在人眼离开时暂停视频播放,也有残障人士通过眼睛打字完成了一本书的写作。

早在2012年,眼控技术研究科技公司Tobii宣布研发出了适配Windows 8的眼控Gaze界面。这是一家做眼球追踪技术较早的瑞典公司。2007年公司估值1400万美元,2009年则达到了2680万美元。2012年,英特尔注资2100万美元进Tobii公司,也是出于对windows 8操作系统一次投资。2014年,Tobii 推出了第二代智能眼镜Glass 2,利用每个镜片配备 2 个摄像头以及相应的软件技术,实现对眼球动作的精准捕捉。

Tobii 智能眼镜

英特尔虽然很早就收购了眼球追踪的公司,但是经过多年,眼球追踪依然未成为笔记本电脑的核心交互方式。而VR的发展却让我们看到了眼球追踪技术应用的更多的可能性。

各大巨头争抢眼球追踪公司 布局VR/AR

目前眼球追踪市场中的主要厂商包括Tobii AB(瑞典)、SensoMotoric Instruments GmbH(德国)、Seeing Machines(澳大利亚)、EyeTracking(美国)、Smart Eye AB(瑞典)、EyeTech Digital Systems(美国)和七鑫易维(中国)等。这些厂商有独立开发产品的,也有和大厂合作研发的。

(1)三星投资FOVE:主打眼球追踪的VR头盔

早在2014年末,FOVE就宣布将会发布一款使用眼球追踪技术的头戴显示设备。在当时,Gear VR发布不久,而Oculus Rift和HTC Vive这些PC VR还没发布。

FOVE头显结合了眼球和头部位置追踪,定位传感等技术,让用户可以用眼睛控制显示器。FOVE一开始在Kickstarter上发起众筹,募集到246566美元。而在2015年,三星风险投资公司投资了FOVE,具体投资金额不详。2016年之时,这家公司A轮融资拿到了1100万美金,并且公布在11月接受预定,售价599美元,价格堪比Oculus。

Fove头显

除了投资FOVE以外,三星自己也在研发眼球追踪的头盔。就在今年7月,一家专注于VR设备眼球追踪的韩国公司Visual Camp称他们正参与研发的一款三星秘密开发的VR一体机——Samsung Exynos VR III。拥有作为领军移动VR头盔Gear VR的三星,其融入了手势识别、眼球追踪的一体机会表现如何呢?

Samsung Exynos VR III 一体机原型

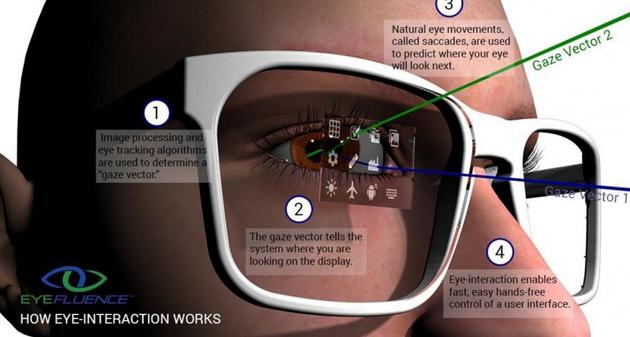

(2)谷歌收购Eyefluence,或为AR交互

2016年10月,谷歌收购了一家专注眼球追踪的初创公司Eyefluence。Eyefluence拥有的AR交互专利将提升高清注视追踪技术,并可通过眼睛进行身份识别和密码保护,也就是说,电脑或手机上的指纹扫描和密码输入将由眼球追踪代替。

增强现实眼镜的交互与笔记本电脑和台式电脑的交互方式发生了显著的变化。当增强现实眼镜把图像呈现在人眼之上时,任何需要触摸的交互都难以实现。依靠眼球追踪的交互方式成为显要的需求。

除了谷歌 Glass以外,谷歌已经与HTC、联想合作计划推出VR一体机,或将具有眼球追踪功能。

(3)Facebook收购The Eye Tribe

2017年1月,Facebook旗下公司Oculus确认收购一家专做眼球追踪的创业公司The Eye Tribe,并且将使用其技术来改善Oculus VR产品。

The Eye Tribe成立于2007年,是一个有16人的创业团队,致力于为多平台提供眼球追踪的软件和硬件。他们已经推出了面向计算机设备的眼球追踪开发者套件,售价99美元,一个面向消费者的眼球追踪盒子,售价199美元。这个眼球追踪盒子可以连接到电脑、平板、手机等多种设备。

The Eye Tribe眼球追踪盒子

(4)苹果收购SMI

2017年6月苹果公司昨天确认收购德国计算机视觉公司SensoMotoric Instruments(SMI)。

这家公司的眼球追踪技术解决了VR常见的短板,它能够以120Hz的采样率实时记录用户的自然凝视行为,可以分析佩戴者的目光,并帮助减少眩晕。

在2016年CES上,SMI与Lumus合作推出了一款带有眼球追踪技术的Lumus DK-50增强现实眼镜。用户能看到AR显示屏幕上的3D图像,并且可以与之互动。

Lumus DK-50

在今年的WWDC(全球开发者大会)苹果公司推出了ARKit,iPhone全面支持AR,一跃成为最大的AR平台。在7月,隐匿三年的谷歌 Glass以企业版的形式宣布回归,但是目前未有消息其应用了眼球追踪技术。苹果将如何整合AR与眼球追踪十分值得关注。

(5)高通、英伟达合作七鑫易维,专注VR底层优化

七鑫易维是国内一家专注眼球追踪技术的公司,成立于2009年,一开始是希望把眼控技术用在谷歌 Glass这样的可穿戴产品上面。

从2013年,他们转向了VR,2016年与HTC合作推出可以应用到Vive上的VR眼球追踪模组“aGlass”。aGlass得到HTC Vive官方认证,可以内置到Vive头显中,为其增加多项基于眼球追踪技术开发的功能,包括注视点渲染、眼控交互、眼动大数据和眼控游戏。

七鑫易维眼球追踪模组"aGlass"

2016年,英伟达确认与北京七鑫易维科技有限公司展开合作,共同助力VR产业。在VR火爆的元年,英伟达确定了VR开发者计划,提供硬件测试平台,推出GameWorksVR方案,向开发者开放NVIDIAVRSDK和提供相应的开发工具。

七鑫易维CEO黄通兵告诉雷锋网:“七鑫易维与英伟达的合作主要是PC VR产品的注视点渲染(Foveated Rendering)技术方面合作,我们需要英伟达底层API和硬件加速支持,才能实现最佳效果,最高降低GPU负荷到原来的十分之一,日后注视点渲染会成为PC VR的标配技术。”

同时,高通在IFA 2016大会上,发布了一款VR一体机参考设计——Snapdragon VR820,目前已经升级的二代搭载骁龙835芯片,能在低功耗下实现良好的图形渲染。高通投资了多家VR公司,在2014年以4000万美元投资七鑫易维。

雷锋网好奇七鑫易维与英伟达和高通这两家公司合作模式的不同,黄通兵表示:“高通在VR领域主要提供移动VR的高性能芯片方案,对于移动VR来说,计算能力相对PC VR较弱,对能耗也更敏感。所以,通过注视点渲染技术降低功耗、发热更加重要。此外,眼球追踪需要充分利用硬件核心来加速,高通在移动处理器中集成眼球追踪相关计算模块也是可以预见的。”

高通骁龙835 VR 一体机参考设计

各大巨头都在收购眼球追踪公司,可见眼球追踪技术已然成为未来人机交互、AR以及VR的基本技术。高通和英伟达作为基础硬件厂商,对于眼球追踪技术的应用能从底层设计上优化VR/AR体验,而三星、谷歌和Facebook这样的VR厂商或许能在应用场景和操作设计上给我们更多的惊喜,当然苹果的举动向来更喜欢出其不意。

眼球追踪解决VR/AR三大问题

Oculus的创始人PalmerLuckey曾表示,眼部跟踪技术会成为VR技术未来的一个“重要组成部分”。不仅能实现注视点渲染技术,它还能用来创造一种视觉深度,以创作出更好的用户界面。

(1)减少眩晕

VR要带给人沉浸感,就要做到能让人在虚拟空间里自然运动,这需要通过运动追踪来改变场景的呈现。目前的VR设备主要是利用空间定位技术来捕捉人的身体的位置运动,用惯性传感器来捕捉人的头部的运动,人在转动头部时,视角会发生相应的变化。

但是这只是比较初级的动作捕捉,人其实大多数时候都是通过转动眼球而不是头部来改变视觉。人们习惯用眼球转动(而不是头部转动)去观察。

目前的VR只追踪头部不追踪眼球运动容易使人眩晕(MotionSickness)。人类对于头部转动和相对应的视野的变化是极度敏感的。如果用户的头转动了,而相对的,视野转动有延迟,只要很微小的延迟就能感觉得到。有多微小呢?研究表明,头动和视野的延迟不能超过20ms,不然就会非常明显。而眼球追踪技术运用在这里正好可以解决这一问题,以眼球的变化来控制场景的变化。

(2)注视点渲染

场景的变化很必要,但是要让VR呈现出同自然世界一样的场景和空间感所需的信息量和计算量是极大的。目前的VR大多数是将全部场景以同等的清晰度来呈现,用户移动头部和身体时虚拟物体也会相应地变换位置,视点拉近和退后都会影响景深,这些变化都需要大量的计算和不断更新。

目前的VR能达到每秒36次的刷新,而要达到人眼场景转换的速度则需要2000-3000次每秒,要实时渲染出这些场景,就连很高配的电脑都达不到。

而事实上,VR根本就不需要也不应该以全部的清晰度来呈现场景里的所有物体。在日常生活中,我们都明白“近大远小”,并且当我们注视一个物体时,这个物体会变清晰而其他物体会变模糊,这样我们看物体才有空间感和景深。如果当我们的视线转移了,画面中的物体还是全部清晰的,那么我们的眼睛就会感到“不适应”,并且会因为处理过多信息而疲劳。

推荐阅读